Responsable: Gabriel TURINICI (voir aussi les interventions de C. Vincent)

Contenu:

1/ Deep learning : applications majeures, références, culture

2/ Types d’approches: supervisé, renforcement, non-supervisé

3/ Réseaux neuronaux: présentation des objets: neurones, opérations, fonction loss, optimisation, architecture

4/ Algorithmes d’optimisation stochastique et preuve de convergence de SGD

5/ Calcul du gradient par « back-propagation »

6/ Implémentation en “pure Python” d’un réseau à couches denses

7/ Réseaux convolutifs (CNN) : filtres, couches, architectures.

8/ Implémentation Keras d’un CNN.

9/ Techniques: régularisation, hyperparamètres, réseaux particuliers: réseaux récurrents (RNN) et LSTM;

10/ Deep learning non supervisé: réseaux génératifs et IA générative (GAN, VAE), Stable diffusion.

11/ Implémentation Keras d’un VAE. Utilisation “Hugginface” de Stable Diffusion.

(12/ Si le temps permet: LLM et NLP: word2vec and Glove: exemples d’utilisation : femme-homme+roi = reine)

| Documents de cours | ||

Document PRINCIPAL pour les présentations théoriques Document PRINCIPAL pour les présentations théoriques(aucune distribution n’est autorisée sans accord ECRIT de l’auteur) |  poly du cours de M1 – évolution (pour back-propagation) poly du cours de M1 – évolution (pour back-propagation) | Preuve convergence SGD (convergence proof english version) |

| Implémentations |

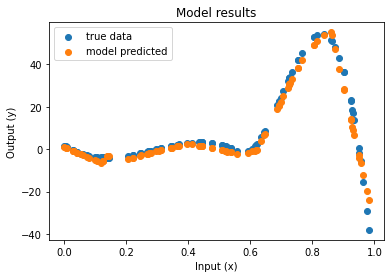

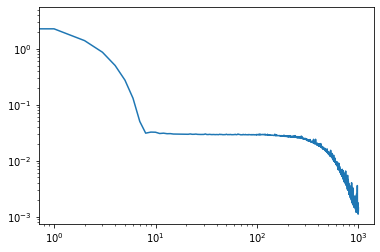

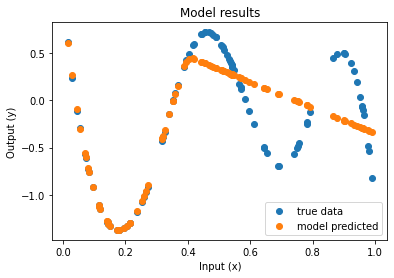

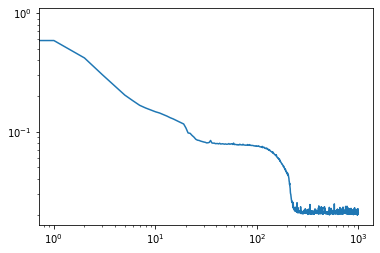

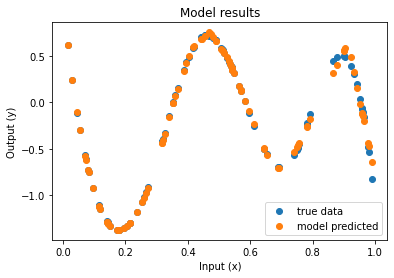

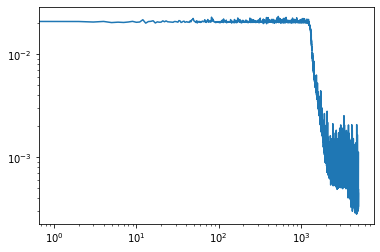

| Code approximation de fonctions par NN : version notebook, version py Resultats (approximation et convergence)     Le même après 5 fois plus d’époques   Référence « officielle » du code: https://doi.org/10.5281/zenodo.7220367 |

| Implementation keras/Iris Autres implémentations: exemple « à la main » A CORRIGER sans Keras ni tf ni pytorch : couches denses (bd=iris), version corrigée – autres implementations : cf. doc. Si besoin : le dataset Iris est ici |

| VAE: version avec visualisation espace latent: CVAE version python (renommer *.py) , CVAE version ipynb |

Stable diffusion: exemple qui marche le 19/1/2024 sur Google collab: version notebook, (ici la version python, changer le nom en *.py). ATTENTION l’exécution initiale prend autour de 10 minutes, ensuite c’est plus rapide (juste changer le prompt). |

Bonjour Monsieur,

J’étais votre étudiante en Méthodes Numériques et Statistiques non Paramétriques cette année en M1 Mathémathiques Appliquées à Paris Dauphine. Je cherche le poly de votre cours de M2 Deep Learning mais je ne le trouve pas sur le site. Pourriez-vous m’y donner l’accès ? Je cherche à approfondir mes connaissances sur le domaine.

Je vous remercie d’avance

Merci pour votre intérêt dans ce cours, j’ai mis en ligne une version qui reprend une grande partie du cours. Le cours contient aussi plusieurs présentations de travaux extérieurs (certains cités dans les transparents, notamment mes travaux dans ce domaine) et aussi des présentations des étudiants que je ne peux pas diffuser pour des raisons de droits d’auteur.

bien cordialement,

G.T.