Teacher: Gabriel TURINICI

Summary:

1/ Deep learning : major applications, references, culture

2/ Types: supervised, renforcement, unsupervised

3/ Neural networks: main objects: neurons, operations, loss fonction, optimization, architecture

4/ Stochastic optimization algorithms and convergence proof for SGD

5/ Gradient computation by « back-propagation »

6/ Pure Python implementation of a fully connected sequential network

7/ Convolutional networks (CNN) : filters, layers, architectures.

8/ Pytorch and Tensorflow(Keras) implementation of a CNN.

9/ Techniques: regularization, hyper-parameters, particular networks, recurrent (RNN, LSTM);

10/ Unsupervised Deep learning: generative AI, GAN, VAE, Stable diffusion.

11/ Keras VAE implementation. “Hugginface” Stable Diffusion.

(12/ If time allows: LLM & NLP: word2vec, Glove (exemples : woman-man + king = queen)

| Documents | ||

MAIN document (theory): see your teams channel MAIN document (theory): see your teams channel(no distribution is authorized without WRITTEN consent from the author) |  for back-propagation for back-propagation | SGD convergence proof |

| Implementations |

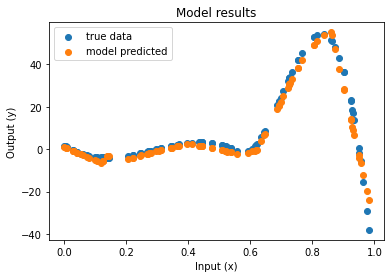

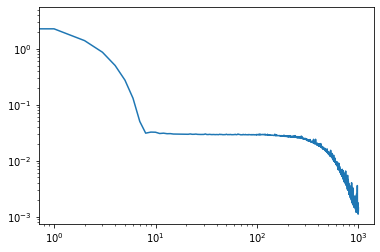

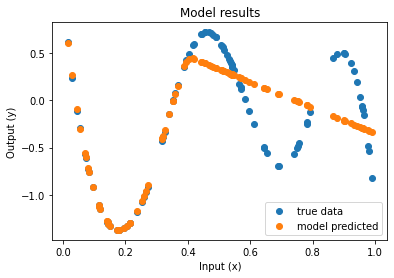

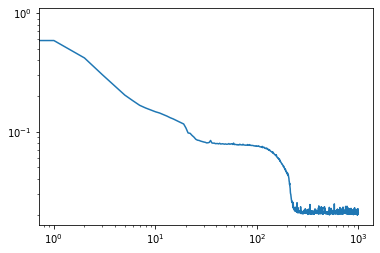

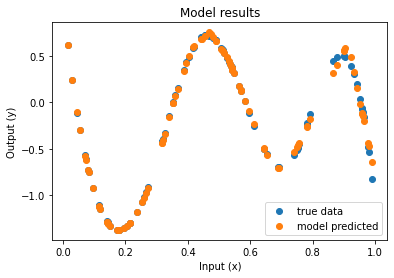

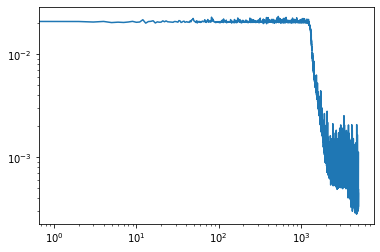

| Function approximation by NN : notebook version, Python version Results (approximation & convergence)     After 5 times more epochs   Official code reference https://doi.org/10.5281/zenodo.7220367 |

| Pure python (no keras, no tensorflow, no Pytorch) implementation (cf. also theoretical doc): – version « to implement » (with Dense/FC layers) (bd=iris), – version : solution If needed: iris dataset here Implementation : keras/Iris , pytorch (tensorflow) CNN example: https://www.tensorflow.org/tutorials/images/cnn Pytorch example CNN/MNIST : python and notebook versions. Todo : use on MNIST, try to obtain high accuracy on MNIST, CIFAR10. |

| VAE: latent space visualisation : CVAE – python (rename *.py) , CVAE ipynb version |

| Stable diffusion: Working example jan 2025: python version, Notebook version Old working example 19/1/2024 on Google collab: version : notebook, (here python, rename *.py). ATTENTION the run takes 10 minutes (first time) then is somehow faster (just change the prompt text).  |

Bonjour Monsieur,

J’étais votre étudiante en Méthodes Numériques et Statistiques non Paramétriques cette année en M1 Mathémathiques Appliquées à Paris Dauphine. Je cherche le poly de votre cours de M2 Deep Learning mais je ne le trouve pas sur le site. Pourriez-vous m’y donner l’accès ? Je cherche à approfondir mes connaissances sur le domaine.

Je vous remercie d’avance

Merci pour votre intérêt dans ce cours, j’ai mis en ligne une version qui reprend une grande partie du cours. Le cours contient aussi plusieurs présentations de travaux extérieurs (certains cités dans les transparents, notamment mes travaux dans ce domaine) et aussi des présentations des étudiants que je ne peux pas diffuser pour des raisons de droits d’auteur.

bien cordialement,

G.T.

Ping : Statistical Learning, M1 Math 2024+ – Gabriel Turinici