Intervention at the round table « Tools, issues and current practice in media boards » at the Dauphine Digital Days held Nov 21-23 2022 at the Université Paris Dauphine – PSL, Paris, France.

Executive summary: software in general and IA is used in many repetitive tasks in media (grammar correction, translation, data search, paper writing when the format is known as ‘trading day report’ or ‘election report’. But same techniques can also be used for more creative tasks, cf. craiyon,(try with « windy day in Paris »), singer, Midjourney gallery (paper on a prize won).

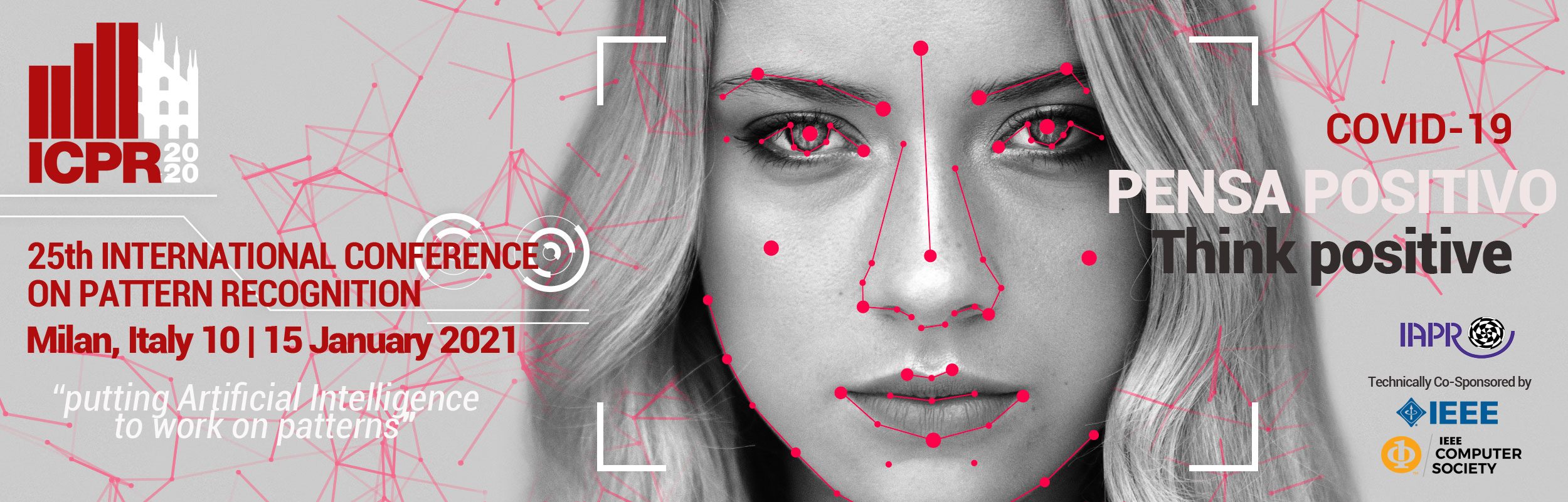

This opens the way to « deep fake » creation ex. youtube deepfake, which is the creation of objects that are fake but that pretend to be true. Deep fakes can and have been used to do harm and we cannot ignore it. Note that fake objects can still impact the real world (rumors can affect people and even the stock market and bansk, etc). But how to distinguish a ‘real’ object from a ‘fake’ one ? Difficult task and not sure the technology can solve it entirely. Some regulation is necessary, see our ![]() deep fakes repport. But ultimately this is within our hands and as always can be tacked with a ounce of good will.

deep fakes repport. But ultimately this is within our hands and as always can be tacked with a ounce of good will.

Conference badge 🙂

Cours 1 : sections 1.1-1.2

Cours 1 : sections 1.1-1.2